1. 引言

在本文中,我们将深入探讨 0-1 损失函数。它是衡量二分类和多分类算法性能的重要指标之一。

通常,损失函数在判断一个机器学习模型是否适用于特定数据集时起着关键作用。

2. 模型质量的衡量

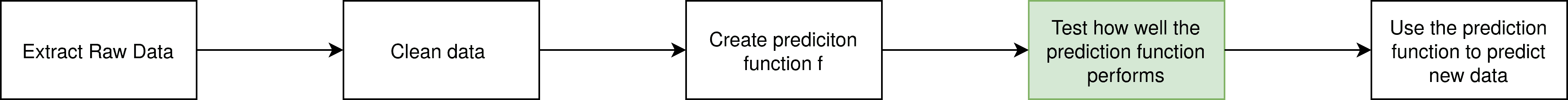

在机器学习流程中,我们通常会经历数据清洗、模型训练、预测函数生成等多个步骤:

图中绿色部分是我们关注的重点:预测函数的质量评估。如何判断我们训练的模型是否真正反映了数据的潜在结构?

评估模型质量可以使用多个指标:损失(Loss)、准确率(Accuracy)、精确率(Precision),还有 F1 分数、召回率(Recall)、AUC 等,但本文我们主要关注前三者。

损失函数:比较预测值和真实值之间的差异。常用的平方损失函数如下:

$$ \mathcal{L}{sq} =\frac{1}{n}\sum^n{i=1}(\tilde{y_i}-y_i)^2 $$

其中 $\tilde{y_i}$ 是真实值,$y_i$ 是预测值。平方操作确保误差为正,并放大了大误差的影响。平均值除以样本数 $n$,以消除样本数量对损失值的影响。

准确率:衡量预测正确的比例:

$$ \text{Accuracy} = \frac{\text{正确分类数}}{\text{总分类数}} $$

精确率:衡量预测为正类的结果中有多少是真正的正类:

$$ \text{Precision} = \frac{\text{TP}}{\text{TP + FP}} $$

TP 表示真正例(True Positive),FP 表示假正例(False Positive)。

3. 示例

为了更直观理解,我们来看一个简单例子:

假设我们有三张图片,任务是判断是否为狗。模型输出的概率分别是 80%、70%、20%,我们设定判断为“狗”的阈值是 70%。而这三张图片实际上都是狗。

损失值(平方损失)计算如下:

$$ \mathcal{L}_{sq} = \frac{1}{3}((1-0.8)^2 + (1-0.7)^2 + (1-0.2)^2) \approx 0.256 $$

准确率为:

$$ \frac{2}{3} $$

因为我们预测了两张为狗(正确),一张为非狗(错误)。

精确率也为:

$$ \frac{2}{3} $$

因为有两个真正例,一个假正例。

4. 0-1 损失函数

0-1 损失函数本质上与准确率等价,只是表达方式不同:

$$ \mathcal{L}{01}(\tilde{y}, y) = \frac{1}{n} \sum{i=1}^n \delta_{\tilde{y_i} \ne y_i} \quad \text{其中} \quad \delta_{\tilde{y_i} = y_i} = \begin{cases} 0, & \text{如果预测正确} \ 1, & \text{如果预测错误} \end{cases} $$

这个函数的含义是:每预测错误一次,就加 1,最后取平均值。

✅ 优点:直观,易于理解

❌ 缺点:不连续、不可导,无法用于梯度下降等优化算法

4.1 加权损失矩阵

在某些场景中,比如疾病诊断,我们更关注“漏诊”(假阴性),此时可以使用加权损失矩阵来调整错误类型的重要性:

$$ A = \begin{bmatrix} 0 & 5 \ 0.5 & 0 \end{bmatrix} $$

第一行表示预测为阴性(负类)时的损失:

- 如果预测正确(TN),损失为 0

- 如果预测错误(FN),损失为 5(高代价)

第二行表示预测为阳性(正类)时的损失:

- 如果预测错误(FP),损失为 0.5

- 如果预测正确(TP),损失为 0

4.2 通用损失矩阵形式

$$ A = \begin{bmatrix} TN & FN \ FP & TP \end{bmatrix} $$

⚠️ 注意:0-1 损失函数本身不可导,因此不能直接用于基于梯度优化的模型。但我们可以使用其他分类算法,如 K-Means 或朴素贝叶斯。

5. 总结

本文我们详细介绍了 0-1 损失函数的定义、与准确率的关系,以及它在分类任务中的应用方式。

✅ 关键点回顾:

- 0-1 损失函数是分类任务中最基础的损失形式之一

- 与准确率等价,但形式更偏向数学建模

- 不连续、不可导,不适合梯度优化

- 可通过损失矩阵调整不同错误类型的代价

如果你在实际项目中遇到对某些错误类型特别敏感的场景,可以考虑使用加权损失函数来优化模型性能。