1. 引言

在本篇文章中,我们将深入讲解 Padding(填充) 技术,这是机器学习尤其是深度学习中非常常见且重要的一个操作。我们将介绍它的基本概念、使用场景、为什么重要,并通过示例说明其工作原理。

2. 什么是填充(Padding)?

在机器学习和卷积神经网络(CNN)中,我们经常使用卷积核(filter)来提取图像中的有用信息,比如边缘、角点、纹理等特征。当一个大小为 的图像与一个

的卷积核进行卷积时,输出的特征图尺寸会缩小为

。

这会带来两个问题:

✅ 图像尺寸逐渐缩小,尤其在深层网络中,可能变得非常小

✅ 图像边缘像素参与卷积的次数远少于中心像素,导致边缘信息被“遗漏”

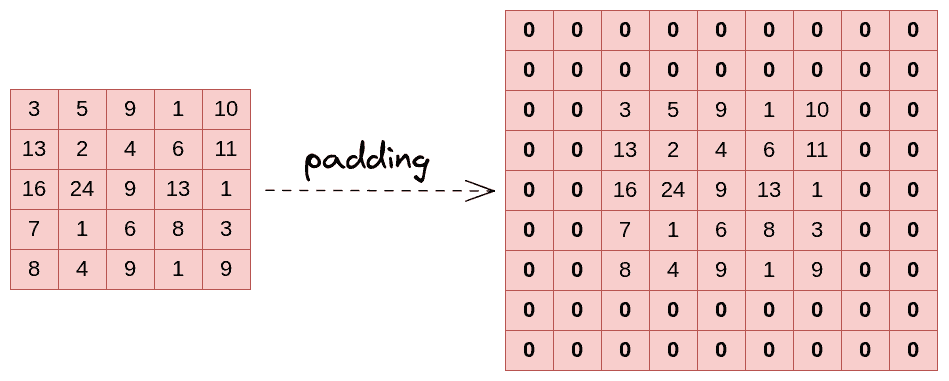

为了解决这些问题,填充(Padding) 被引入。它通过在输入矩阵的边缘添加额外元素(通常是0),来保持输出尺寸与输入一致或满足特定要求。

下图展示了一个典型的填充操作:

3. 填充的类型

常见的填充方式有三种:

3.1 Same Padding(同宽填充)

Same Padding 的目标是让输出特征图的尺寸与输入一致。为此,它会在图像四周均匀添加若干层0值像素。

例如,假设输入为 ,卷积核大小为

,那么填充的大小为:

$$ p = \frac{f - 1}{2} $$

这样卷积后的输出尺寸仍为 。

3.2 Valid Padding(有效填充)

Valid Padding 表示不添加任何填充。卷积只在输入图像的有效区域上进行,因此输出尺寸小于输入尺寸:

$$ \text{输出尺寸} = n - f + 1 $$

这是默认的填充方式,适合你明确希望图像尺寸逐步缩小的场景。

3.3 Causal Padding(因果填充)

这种填充方式主要用于序列模型(如时间序列预测、Transformer 等)中的一维卷积操作。它只在输入序列的起始位置添加填充,以保证在预测当前时间步时,不会“看到”未来的信息。

⚠️ 注意:这种填充方式在图像处理中不常用,但在 NLP 或时间序列建模中非常关键。

4. 为什么使用填充?

填充在深度学习中非常重要,主要有以下几点原因:

- ✅ 防止信息丢失:图像边缘像素参与卷积的机会少,容易丢失重要信息,填充可以缓解这一问题。

- ✅ 保持图像尺寸不变:尤其在深层网络中,如果不填充,图像尺寸会迅速缩小,不利于后续特征提取。

- ✅ 保持空间结构信息:有助于保留图像或序列的空间结构,避免特征错位。

- ✅ 简化网络设计:通过控制填充方式,可以更灵活地设计网络结构,而不需要额外处理尺寸变化。

5. 填充的优缺点

5.1 优点

- ✅ 提高模型性能,保留边缘信息

- ✅ 保持输入输出尺寸一致,方便网络设计

- ✅ 简化数据预处理流程,减少手动调整尺寸的麻烦

5.2 缺点

- ❌ 增加了计算量和内存消耗,因为填充后矩阵更大

- ❌ 填充的0值可能引入噪声或干扰信息

- ❌ 在某些场景下可能导致过拟合(如填充过多、模型对边缘信息过于敏感)

6. 总结

本文介绍了深度学习中的一个重要技术 —— 填充(Padding),它在图像处理、序列建模、时间序列预测等多个领域都有广泛应用。

我们讲解了:

- 填充的基本概念

- 常见的三种填充方式:Same、Valid、Causal

- 填充的原理和作用

- 使用填充的优缺点

掌握好填充技术,不仅能帮助我们更好地设计模型结构,还能提升模型的性能和稳定性,是深度学习工程师必须掌握的基础技能之一。