1. 引言

随着人工智能和机器学习技术在企业中的广泛应用,MLOps(Machine Learning Operations)已从一个流行术语迅速转变为一项必不可少的工程实践。

与传统软件开发不同,机器学习系统具有高度的数据依赖性,其模型性能会随着时间推移、数据分布变化而下降。因此,构建一套标准化的流程来管理模型的全生命周期,已成为从实验室研究到实际生产部署的关键需求。

本文将深入探讨 MLOps 的核心概念、其与 DevOps 的区别、构建 MLOps 流水线的关键阶段,以及在金融领域(如银行反欺诈)中的实际应用案例。

2. 什么是 MLOps?

MLOps 是机器学习、数据工程和软件工程实践的融合,旨在为机器学习模型的开发、部署和运维提供标准化流程。

它覆盖了从模型训练、验证、部署到持续监控的整个生命周期,是连接数据科学家与运维团队的桥梁。通过引入 MLOps,团队可以更高效地协作,提升模型在实际场景中的表现和稳定性。

3. 从 DevOps 到 MLOps 的演进

DevOps 在传统软件开发中已广泛应用,但在机器学习系统中存在明显局限。与软件开发不同,机器学习严重依赖数据。一旦数据分布发生变化,模型性能将显著下降。

因此,MLOps 应运而生,专门应对机器学习系统在数据依赖性、模型漂移和持续监控等方面的挑战,推动模型从实验室到生产环境的高效落地。

4. 构建稳健的 MLOps 流水线

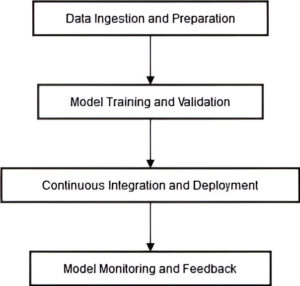

一个完整的 MLOps 流水线通常包括以下核心阶段:

- 数据采集与预处理

- 模型训练与验证

- 持续集成与部署(CI/CD)

- 模型监控与反馈机制

如下图所示:

接下来我们将逐一介绍每个阶段。

4.1 数据采集与预处理

这是 MLOps 流水线的第一步,涉及从多个来源收集原始数据。

常见问题包括:

- 数据缺失

- 异常值

- 数据格式不一致

✅ 处理建议:

- 使用 Apache Spark 进行大规模数据清洗

- 使用 Apache Kafka 实时采集数据流

- 实施数据版本控制(如 DVC)

⚠️ 踩坑提醒:数据预处理阶段如果没有良好的版本控制机制,后续模型迭代时将难以复现训练过程。

4.2 模型训练与验证

在数据准备完成后,进入模型训练阶段。此阶段需完成以下任务:

- 算法选择(如 Logistic Regression、XGBoost、深度学习等)

- 超参数调优(Grid Search / Bayesian Optimization)

- 模型评估(Cross Validation、AUC、Precision/Recall)

常用工具:

- TensorFlow / PyTorch(深度学习)

- Scikit-Learn(传统 ML)

- AutoML 工具(如 AutoGluon、H2O.ai)

✅ 示例代码(使用 Scikit-Learn 进行交叉验证):

from sklearn.model_selection import cross_val_score

from sklearn.ensemble import RandomForestClassifier

model = RandomForestClassifier()

scores = cross_val_score(model, X_train, y_train, cv=5)

print("Average accuracy:", scores.mean())

4.3 持续集成与部署(CI/CD)

MLOps 中的 CI/CD 是自动化模型迭代和部署的核心环节。

主要目标包括:

- 自动化测试(数据格式校验、模型性能验证)

- 自动构建模型镜像(如 Docker)

- 自动部署(Kubernetes / Kubeflow / Jenkins)

常用工具:

- Jenkins

- GitHub Actions

- Kubeflow Pipelines

✅ 示例:GitHub Actions 配置模型训练流水线

name: Model Training Pipeline

on: [push]

jobs:

train:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v2

- name: Setup Python

uses: actions/setup-python@v2

- run: pip install -r requirements.txt

- run: python train.py

4.4 模型监控与反馈机制

模型部署后,持续监控其在生产环境的表现至关重要。

监控内容包括:

- 模型预测准确性

- 推理延迟

- 数据漂移(Data Drift)

- 模型漂移(Model Drift)

常用工具:

- Prometheus(指标采集)

- Grafana(可视化)

- Evidently AI(漂移检测)

✅ 建议:

- 设置性能阈值触发自动告警

- 定期触发模型重训练(基于新数据)

5. 应对数据漂移与模型漂移

数据漂移是指输入数据分布随时间发生变化,模型漂移则是模型预测性能下降。

✅ 常见应对策略:

- 定期使用新数据重新训练模型

- 使用漂移检测工具(如 Evidently、NannyML)

- 构建自动化重训练流水线

⚠️ 踩坑提醒:忽略数据漂移可能导致模型性能骤降,尤其是在金融、电商等快速变化的业务场景中。

6. 案例分析:银行反欺诈系统中的 MLOps 实践

6.1 数据管理与版本控制

某银行构建实时反欺诈系统,需处理来自多个渠道(如 ATM、网银、POS)的交易数据。

使用工具:

- Apache Spark(数据清洗与特征工程)

- DVC(数据版本控制)

- 特征工程包括:

- 交易频率

- 地理位置异常

- 金额分布

6.2 模型开发与训练

使用 Python 框架开发模型:

- Scikit-Learn(逻辑回归、决策树)

- TensorFlow(深度学习)

通过 AutoML 工具进行超参数优化,选择在召回率和精确率之间取得平衡的模型。

6.3 CI/CD 模型部署

使用 Jenkins + GitHub Actions 构建自动化流水线:

- 模型训练完成后自动运行测试

- 测试通过后构建 Docker 镜像并部署至 Kubernetes 集群

✅ 示例:Docker 部署模型服务

FROM python:3.9

COPY . /app

WORKDIR /app

RUN pip install -r requirements.txt

CMD ["uvicorn", "main:app", "--host", "0.0.0.0", "--port", "8000"]

6.4 模型监控与性能跟踪

部署 Prometheus + Grafana 监控平台:

- 实时追踪模型准确率、延迟、错误率

- 设置阈值触发自动重训练

6.5 合规与治理

为满足金融监管要求,银行实施以下措施:

- 记录模型训练数据来源

- 存档每次模型评估指标

- 提供完整模型开发与部署历史记录

✅ 优势:

- 提高审计透明度

- 支持模型可解释性(如 SHAP 值分析)

6.6 MLOps 带来的收益

- 模型上线时间从数周缩短至数小时

- 实现模型自动重训练与部署

- 显著提升欺诈识别准确率,减少误报

- 提升客户信任与企业盈利能力

7. MLOps 实施的最佳实践

7.1 自动化重复任务以提升效率

✅ 推荐工具:

- Apache Airflow(任务编排)

- GitHub Actions / Jenkins(CI/CD)

- Prometheus(监控 + 自动触发)

⚠️ 踩坑提醒:手动执行模型训练和部署容易出错,应尽可能自动化。

7.2 确保可复现与透明性

在多团队协作环境中,可复现性是关键:

- 使用 Git 管理代码版本

- 使用 DVC 管理数据版本

- 使用 MLflow 管理模型和实验记录

✅ 示例:MLflow 记录实验

import mlflow

mlflow.set_experiment("fraud-detection")

with mlflow.start_run():

mlflow.log_param("max_depth", 5)

mlflow.log_metric("accuracy", 0.95)

mlflow.sklearn.log_model(model, "model")

7.3 促进跨职能团队协作

MLOps 成功的关键在于数据科学家、机器学习工程师、运维团队之间的紧密合作。

✅ 实践建议:

- 建立跨职能团队

- 使用 Slack、Teams 等工具进行日常沟通

- 定期举行模型评审会议

8. 总结

MLOps 是推动机器学习模型从开发到部署落地的关键工程方法。它通过自动化、可复现性和团队协作,解决了数据漂移、模型漂移和运维复杂性等挑战。

在银行反欺诈案例中,MLOps 不仅提升了模型部署效率,还显著增强了模型的稳定性和可维护性。

随着机器学习在各行业的深入应用,MLOps 将成为支撑企业 AI 能力的核心基础设施。